Es wurden schwerwiegende Probleme bezüglich des Status Ihrer Webseite gefunden. Diese Meldung in den Google Webmaster-Tools kann in nicht wenigen Fällen einen ernsthaften Schock unter Bloggern und Betreibern von Webseiten auslösen. Die Ursache dieser Meldung liegt meist an einem Problem der Indexierung durch den Googlebot. Dieser wird durch die Datei robots.txt ausgesperrt, wodurch die Seiten nicht im Google-Index erscheinen, bzw. im schlimmsten Fall aus dem Index entfernt werden.

Von robots.txt abgelehnt – Was nun?

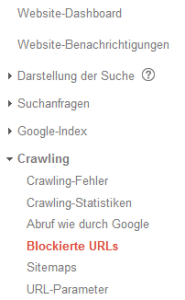

Für den Fall, dass diese oder eine ähnliche Meldungen in den Google Webmaster-Tools angezeigt wird, sollte zunächst der Inhalt der Datei robots.txt im Root-Verzeichnis der Webseite überprüft werden. Dies kann entweder über einen FTP-Client erfolgen, oder einfacher, Sie rufen in den Webmaster-Tools die Seite Blockierte URLs im Menü Crawling auf. Dort erfahren Sie einerseits, wann die robots.txt zuletzt von Google ausgelesen wurde und, weiter unten, auch den Inhalt der zuletzt abgerufenen Datei. Hier ist es wichtig zu wissen, dass Google die Informationen der robots.txt nicht in Echtzeit aktualisiert, sondern ungefähr in einem 24-48h Intervall.

Es kann also gut sein, dass die Inhalte der robots.txt bei Google nicht aktuell sind, insbesondere wenn Sie gerade erst Änderungen vorgenommen haben. Die aktuell gültige robots.txt Ihrer Webseite finden Sie übrigens immer unter http://www.meineseite.de/robots.txt. Wird keine Seite gefunden, haben Sie keine robots.txt im Einsatz (was auch nicht nötig ist). Sind die Einstellungen in der abgerufenen Datei richtig müssen Sie einfach warten.

Sollten Sie jedoch z.B. folgenden Eintrag entdecken, müssen Sie unverzüglich handeln:

User-agent: *Disallow: /

In diesem Fall verweigern Sie jeglichen Bots von Suchmaschinen, Ihre Webseite zu indexieren. Eine mögliche und weitverbreitete Ursache könnte eine Einstellung in Ihrem CMS oder Blogsystem sein. So kann beispielsweise in WordPress eine Einstellung aktiviert werden, die genau dies tun soll, nämlich die Webseite vor der Erfassung von Suchmaschinen schützen (Einstellungen -> Lesen -> Suchmaschinen-Sichtbarkeit). Entfernen Sie dieses Häkchen, wird die robots.txt automatisch angepasst und wird beim nächsten Durchlauf in den Webmaster-Tools aktualisiert. Wichtig: WordPress schreibt eine virtuelle robots.txt, d.h. die Datei ist per FTP-Client nicht sichtbar).

Sofern von der eben genannten Ursache nicht betroffen sind, sollten Sie die im root-Verzeichnis vorhandene robos.txt anpassen. Anleitungen sowie Generatoren finden sich dazu im Internet zu genüge. Wenn die Webseite ohne Ausnahmen indexiert werden soll können Sie die Datei auch einfach komplett entfernen.

Den Googlebot manuell vorbei schicken?

Auf diese Frage gibt es eine einfache Antwort: Geht nicht. Auch wenn hier und da geschrieben steht, dass durch Einreichen einer neuen Sitemap oder durch den Blockierte URLs Test die temporär gespeicherte robots.txt aktualisiert wird, es funktioniert nicht! Der Googlebot schaut in der Regel alle 24 Stunden vorbei. Länger als 48 Stunden hat es meiner Erfahrung nach noch nicht gedauert. Über den Punkt Blockierte URLs können Sie den aktuellen Status jederzeit überprüfen. In der Spalte Heruntergeladen finden Sie den Zeitpunkt der letzten Aktualisierung durch Google.

Ebenfalls interessant:

Dieser Artikel ist wie alle anderen auf dieser Seite kostenlos für Dich und ich hoffe, ich konnte Dir weiterhelfen. Wer möchte, kann diesem Blog eine kleine Aufmerksamkeit in Form einer kleinen Spende (PayPal) oder über die Amazon Wunschliste zukommen lassen.

Letzte Aktualisierung am 2024-11-21 / Affiliate Links / Bilder von der Amazon Product Advertising API

Hallo René,

danke für deinen Lösungsansatz. Heute bekam ich die freundliche „Ermahnung“ von Google. Nachdem ich bei Firefox die nervige Meldung sah: „Verbindung ist nicht sicher“, habe ich versucht, alle http auf https umzuleiten. Heute habe ich deinen Ansatz befolgt und die Suchmaschinen-Sichtbarkeit in WordPress stattgegeben. Mal schauen, was in den nächsten Tagen/Stunden passiert. Natürlich habe ich auch Google erlaubt, die Abdeckungsprobleme zu prüfen.

Danke für diese Lösung. hat mir und der Webseite sehr gut geholfen ! Ich wünsche schon mal Frohe Weihnachte und einen guten Rutsch ins neue Jahr